DeepSeek新模型让硅谷“失眠” 开源阵营的“反击夜”

2025年年底,本以为全球大模型的话题中心已经被Google牢牢抢走。Gemini 3 Pro上线后,在一系列权威评测中压制所有开源模型,闭源阵营重新站上技术制高点,“开源是不是到头了”“Scaling Law是不是撞墙了”的声音在业内此起彼伏,开源社区一度弥漫出一种隐隐的低气压。

就在这种节点上,DeepSeek没有选择退到边线观望,而是把牌一口气摊在桌面上。12月1日,它直接抛出两款新模型:在推理能力上对标GPT-5、整体表现逼近Gemini 3 Pro的DeepSeek-V3.2,以及在数学、逻辑和复杂多轮工具调用上表现异常突出的Speciale版本。这既是一次集中秀肌肉,也是对“闭源新天花板”的正面回应——而且是在算力资源并不占优的前提下。

换句话说,这已经不是一次常规意义上的“版本升级”,而更像是DeepSeek对“后Scaling时代”路线的一次公开下注:当继续简单堆规模不再是唯一答案,如何凭架构和训练方式把差距补回来?如何用更少的token,跑出更像“智能体”、而不是“聊天补全器”的行为?以及——为何要在开源阵营中第一个把Agent抬到战略高度?

围绕这些问题,DeepSeek给出了一套相对完整的技术路径和系统叙事。

在大模型的第一阵营里,开源一直被认为“最多追平,难以对抗”。这一次,DeepSeek-V3.2交出来的成绩单,已经不太像传统意义上的追赶者。

按照DeepSeek对外披露的数据,V3.2在公开推理类评测中的整体表现,已经可以与GPT-5同场对比,仅在少数项目上略逊于Gemini 3 Pro。在多项关键指标上,它稳定超越Kimi-K2-Thinking,刷新国内开源模型推理能力的最好纪录。在数学计算、复杂逻辑、多步推演等任务上,V3.2已经具备和领先闭源模型掰手腕的实力,基本站到了“全球第二梯队”的前排位置。

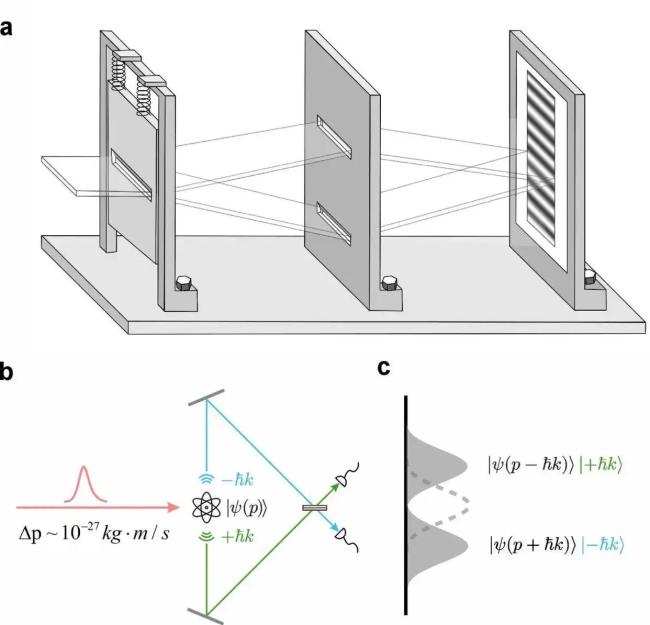

这背后起决定性作用的,并不是简单地“模型再放大一点”,而是对底层架构的重新动刀。最典型的,就是DeepSeek在V3.2中引入的稀疏注意力机制(DSA)。

传统Transformer里,注意力需要让每个token和前面几乎所有token“打招呼”,计算量随着上下文长度呈平方级攀升,长上下文一上来,推理成本立刻飙升。DSA做的事,说白了就是:“别再对所有人一视同仁,把算力先省出来,只算真正有用的那一部分。”

为此,DeepSeek在注意力模块前加了一层“闪电索引器”(Lightning Indexer)。这个模块本身可以用极少的参数、在FP8这样的低精度下运行,负责在极短时间内做一轮粗筛,先找出与当前token最关键的一小撮上下文位置,再把主算力集中投向这部分核心token。这样一套组合拳打下来,注意力的复杂度从近乎N²,被压缩到了接近线性。

更关键的是,DeepSeek并没有一上来就用稀疏结构“硬替换”。在预训练前期,模型仍然采用标准的密集注意力,而索引器则负责在旁边“学分布”,逐步拟合原有注意力的权重模式;等到后期模型稳定后,再用稀疏结构从密集注意力手中接管大部分工作。这种“先模仿、再接管”的渐进式过渡,使得V3.2在128K甚至更长上下文下,既大幅减轻了计算压力,又没有明显牺牲精度。在Fiction.liveBench、AA-LCR等长文本基准测试中,V3.2在信息召回、上下文一致性以及压缩表达上的表现,均明显好于上一代。

如果说DSA是在“算得更经济”,那么另一个不太容易被外行察觉的关键点,则是在“怎么把每一步思考用得更值”。

在V3.2里,DeepSeek首次系统性提出了“Thinking in Tool-Use”的工具使用范式。以前大多数模型调用工具的流程,是“想一想→调工具→给答案”,调用工具像是插在思维链条中间的一块“硬隔板”。V3.2改造后的执行逻辑,则更像是“边想边调”:模型可以先推一段逻辑,再调一次工具,拿到结果后继续在原来的推理轨迹上接着想,再视情况调下一次工具……整个过程交错前进。

这套模式与Agent领域近一年热炒的“Interleaved Thinking”不谋而合。对于现实世界的复杂任务而言,这种能力要比单次大爆发式推理重要得多。真实场景里,任务往往要先搜集一轮信息、再验证、再拆解子任务、再修正路径,如果每调一次工具,模型的“思路”就被截断一次,那它就只能不停重来——既浪费token,也容易在反复重启中丢失关键线索。

V3.2在底层做的改动,是把“推理轨迹”当成上下文中的固定资产,工具调用不会刷新这条轨迹,只会在其后追加新思考。工具返回新信息之后,模型继续沿着原先的思路往下推,而非重开一局。这既让同一任务中的中间状态可以反复复用,也显著减少了毫无必要的重复生成。

综合来看,这一代DeepSeek的进步,更像是一次“算力配置逻辑”的重写:在算力总盘子并不占优的情况下,通过更聪明的架构设计和推理方式,把每一点浮点数都用到刀刃上。DSA负责把“该算的算得更专注”,交错思维负责让“每一步思考带来的信息收益更大”,两者叠在一起,指向的都是同一个目标——从一个“大号补全器”,走向一个更接近“持续思考的智能体”。

从这个意义上讲,在参数规模红利逐渐见顶之后,接下来的竞争,注定会从“谁更大”转向“谁更会用算力”和“谁能组织起更长、更稳定的思维链条”。V3.2算是这个方向的一个相对成熟的样本。

如果说架构上的变化让V3.2站稳了技术底座,那么在战略路线上的明显拐弯,则体现在一个关键词上——Agent。

过去一年,业界对Agent的话题并不少,但大部分厂商仍把它当作模型能力之上的“外挂能力”:有就加一层,没有也不至于影响大盘。DeepSeek这次则把话说得很直接——在它的技术文档和对外阐释中,“Agent能力”和“推理能力”被放在了同一高度。

这一判断并非空穴来风。过去一段时间,不少企业率先感受到的是:单纯“更会聊天”的模型,其业务边际效益在不断递减。反而是会“下手干活”的Agent,比如自动生成月报、批量处理客服工单、自动跑流程、替程序员修小bug,才是真正能闭环并被愿意付费的东西。

DeepSeek正是围绕这一趋势重构了训练路径——在V3.2的后训练阶段,它搭了一整套针对Agent的训练体系,而不是简单在模型外再缝一个“Agent框架”。据披露,团队自建了超过1800个模拟环境,并围绕这些环境自动生成了大约8.5万条复杂任务提示和任务轨迹。这些轨迹不是靠人工一条条写出来,而是借助环境构建器和轨迹打分系统自动合成,再通过强化学习不断迭代。

这种做法,实际上是在绕开“继续砸海量对话数据”的老路。与传统的聊天语料相比,Agent任务具备更强的结构化、可验证性以及高度稀缺性——一旦建立起足够丰富的任务环境,同一环境在后续训练中可以被反复利用,带来的“能力增量”要远高于再加一批闲聊对话。

为了让模型真正学会在这些环境里“行动”,DeepSeek继续沿用了GRPO(Group Relative Policy Optimization)这一强化学习策略,并按自家场景做了大量本地化改造。模型训练优化的目标,不再只是“回答对不对”,而是同时要兼顾:任务有没有完成、推理过程是否连贯、语言表达是否稳定、工具使用是否合理自然。为此,DeepSeek没有采用单一维度的奖励,而是把任务完成度、推理合理性、语言质量等拆成多维信号,让模型在训练中尽量避免“顾此失彼”。

做这一切,还有一个前提:模型要有足够强的“状态感知能力”,能在多轮任务中记住自己已经做过什么、当前在第几步。这就回到了前面提到的上下文管理——V3.2在系统级别规定:只有当用户发出新指令时,模型才会重置思考状态;在同一个任务内部,不论调用多少次工具,推理轨迹都被完整保留下来。这种设计直接保证了Agent行为链条的连续性,使得模型有能力承接更长、更复杂的跨阶段任务。

站在系统架构的视角看,DeepSeek对Agent的理解已经明显超出“给模型加个自动化壳子”的层面,更接近于把Agent当作“模型操作系统”的一部分。模型本体是内核,Agent是围绕内核调度资源的执行层,外部工具则像是一个个模块化驱动。谁能先把这套“模型OS+Agent标准”跑通并跑稳,谁就可能抢先拿到下一阶段生态的主导权。

也因此,DeepSeek这次不只是实现了“交错式思考+工具使用”的技术路径,还刻意给这套范式起了一个明确的名字——“Thinking in Tool-Use”。这既是技术标签,也是对未来平台规则的一种预埋。

对于整个行业来说,这标志着一个不太容易回头的分界线:Agent不再是“可选项”,而开始变成大模型中长期竞争力的必要组成。未来看一款模型,不再只是看它在标准榜单上的分数,更要看它在真实环境里的执行链条和Agent表现。

当然,哪怕有V3.2和Speciale这一波高光表现,DeepSeek并没有掩饰开源与闭源之间仍然存在的现实差距。

一方面,在世界知识的广度和最新信息的覆盖上,开源模型受限于数据获取渠道和更新频率,短期内很难与手握巨大私有数据池的闭源巨头完全持平。另一方面,在极端复杂任务(例如跨领域、多阶段专业决策)以及token生成效率上,开源体系仍然处于被动追赶的位置。

DeepSeek选择承认这些不利因素,然后把精力押在“后训练战术”上:既然参数规模和预训练预算追不上,就尽可能把后训练过程做深、做精。

为此,它设计了被内部称为“后训练三板斧”的组合:专家蒸馏、多轨强化学习,以及工具思维融合。

所谓专家蒸馏,是在通用大模型之外,再训练一批高度“偏科”的小模型。DeepSeek为V3.2准备了六类专家,分别专攻数学、编程、逻辑推理、通用Agent、Agent编程和Agent搜索等方向。它们不直接面向用户,而是用来自行生成高质量示范样本,再把这些样本喂回主模型,相当于用多个“小学霸”的解题过程去“喂养”一个通才,让通才在后训练阶段集中吸收各领域的成熟解题套路。

多轨强化学习则是第二步。DeepSeek在V3.2上延续了GRPO框架,但调整了奖励设计与训练项目结构,让模型不止优化“最终答对没”,还要优化“怎么一步一步做对”。大约超过整体预训练算力预算10%以上的额外资源,被投入到了这一阶段,在开源模型里,这样的后训练比例并不多见。

第三部分,则是把工具使用习惯直接融入模型的“思考方式”。刚开始训练时,模型并不知道“什么时候该调工具,什么时候自己算”,更不懂“调用后如何接着自己的思路往下推”。为此,DeepSeek在系统提示中大量加入了人造示例,告诉模型在什么场景下应该自然地把工具调用嵌进推理链,而不是像过去那样“先想完,再补一个工具调用”。随着训练反复迭代,模型逐渐从“模仿”走向“内化”。

为了减轻token负担,DeepSeek再次动了上下文结构的手术刀——工具调用不再清空思考内容,只有用户发出新问题时才重置场景。这既压缩了重复内容带来的token膨胀,也让模型在一次任务中可以持续利用前面已经展开的推理链。

归根到底,这一系列做法都围绕着同一个核心思路:在规模受限的情况下,想办法提高“单位token的含金量”,让每一次推理、每一段输出,都尽量承载更多有用的信息,而不是把算力浪费在重复和无效生成上。

当然,靠一两代产品,开源不可能立刻翻过闭源巨头筑起的那道高墙。一边是Gemini 3 Pro代表的“极致规模+资源堆叠路线”,另一边是以DeepSeek为代表的“架构创新+后训练强化路线”,两条路径接下来很可能会在不同场景下长期并存。前者在通用性和知识深度上仍然占优,后者则试图用更高的能效比和更强的推理组织能力,去争取一条“以小搏大”的穿透通道。

从这个角度看,DeepSeek这次带来的,并不只是两份新模型报告,而是对“开源是否还有机会追上闭源”的一次阶段性回答:规模差距短期难以消除,但只要在架构、Agent和后训练方法上持续加码,开源并非没有机会在某些关键能力带上实现对闭源的局部反超。

至少,在2025年的这个冬天,硅谷那些原本以为“大局已定”的技术团队,多少又得重新算一遍账了。

相关新闻

DeepSeek推出金牌级数学模型 开源新AI模型

2025-11-28 15:47:58DeepSeek推出金牌级数学模型DeepSeek新模型有多猛 开源AI的重大突破

DeepSeek最新发布的开源数学模型DeepSeekMath-V2,在全球最难的高中数学竞赛中达到了金牌水平,成为首个实现这一成就的开源模型,标志着开源人工智能在复杂推理能力上的一次重大突破

2025-11-28 15:24:50DeepSeek新模型有多猛DeepSeek推出新模型 数学推理达IMO金牌水平

11月27日晚,DeepSeek在Hugging Face上开源了一个新模型:DeepSeek-Math-V2。这是一个数学模型,也是目前首个达到IMO金牌水平且开源的模型

2025-11-28 10:26:50DeepSeek推出新模型DeepSeek开源新模型DeepSeek-OCR 探索视觉-文本压缩边界

10月20日,人工智能团队DeepSeek AI发布了全新多模态模型 DeepSeek-OCR

2025-10-20 20:33:14DeepSeek开源新模型DeepSeek-OCRDeepSeek使用率暴跌 原因何在?新模型R2缺席影响显著

由于新模型R2迟迟未发布,DeepSeek近期备受关注。国际知名半导体研究机构Semianalysis的报告显示,DeepSeek的用户使用率从年初的7.5%峰值显著下降至3%,官网流量同期下滑近三成

2025-07-10 13:25:04DeepSeek使用率暴跌原因何在DeepSeek为何发表研究成果 揭示AI模型秘密

证券时报的文章内容仅供参考,不构成实质性投资建议,据此操作风险自担。下载“证券时报”官方APP或关注官方微信公众号,可以随时了解股市动态,洞察政策信息,把握财富机会

2025-09-20 12:51:47DeepSeek为何发表研究成果