危险程度堪比核武?“杀人机器”研发或引发灾难

原标题:危险程度堪比核武?“杀人机器”研发或引发灾难

参考消息网5月14日报道 美国石英财经网站5月11日发表了贾斯廷·罗尔利希的题为《“第3次战争革命”是能够自己决定杀人的武器》的文章,现将原文编译如下:

自主致命性武器——批评者称之为“杀人机器人”——的出现让许多分析人士感到惊恐。在没有人类近距离控制的情况下,装备了人工智能的某些此类武器能以士兵无法企及的速度和效率选定并消灭目标。

包括美国在内的多个国家正在研发自主致命性武器,相关项目包括装备人工智能的无人坦克、无人战斗机等。

各国就此自行实施了一些准则,但专家说这些还不够。美国军方政策规定,无人武器装备作出开火决定时必须有“适当程度的”人类判断,但并未对此作出明确定义,而且允许有例外。美国也是反对在该领域进行国际监管的少数国家之一。

不过,担心爆发军备竞赛的荷兰非政府组织“和平”反战组织最新发表的报告称,要想防止最终的灾难,除了全面禁止之外别无选择。

资料图片:科幻电影《终结者》中的天网机器人。(图片来源于网络)

资料图片:未来士兵想象图。(图片来源于网络)

这种担忧不无道理。人工智能专家认为这种武器将引发“第3次战争革命”。和前两次战争革命——黑色火药和核弹——一样,此类武器系统能迅速证明其价值,让拥有它们的一方获得几乎不可超越的技术优势。

如果不加以禁止,人工智能武器可能在全世界的军队中投入使用。就像社交媒体一样,在相关公司强烈抵制——而同时技术还在飞速发展——的情况下,试图到后来再回溯性地实施监管将被证明困难重重。

正如“和平”组织所声称的,“将生死决定权交给机器或算法是极不道德的”。

问题是,我们会及时行动起来吗?对于人工智能武器,快速采取行动极为重要。

推荐阅读

西班牙点球大战遭淘汰 葡萄牙大胜瑞士晋级

新华网2022-12-07 10:05:29

中方支持联合国在国际人道救援中发挥组织协调作用

新华网2022-12-07 08:03:44

美陪审团裁定特朗普集团两家公司税务欺诈等罪名

新京报2022-12-07 07:57:06

韩国财阀与前总统女儿离婚 并承认自己有婚外子女

海外网2022-12-07 09:41:49

男子买饼需求全被老板说服?网友:没见过这样的pua!

2022-12-07 10:17:45

胡锡进:我不相信这个国家里会有绝对反对放开封控的人

胡锡进2022-12-07 09:44:10

乌媒:泽连斯基发视频,透露自己在顿巴斯地区 ,庆祝乌克兰“建军节”

新京报2022-12-07 09:11:19

落马区委书记贪腐上亿元,被判19年!刚当区长就安排2人伺候

2022-12-07 10:10:05

曝赖清德对接任民进党主席犹豫不决 民进党各派系明争暗斗

海峡导报2022-12-07 09:27:44

世界杯死亡之组4队全部回家 西班牙日本死于点球战

2022-12-07 09:40:14

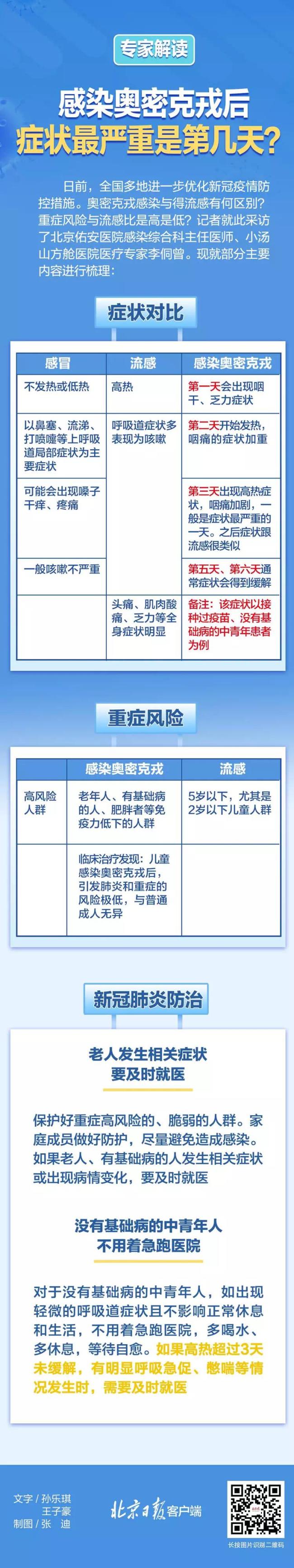

感染奥密克戎后第几天症状最严重?一图读懂

2022-12-07 09:41:48

以色列海上新盾“C-穹顶”问世

海洋防务前沿2022-12-07 09:21:45

金毛眼球被抠流落街头被救后离世 多狠毒的心下得去手呢

2022-12-07 10:13:10

专家说新冠肺炎应更改名称:改为新冠病毒传染病

2022-12-07 09:35:40

网红主播在尼泊尔被杀 其亲属回应:他平时爱好旅游

上游新闻2022-12-07 09:51:52

韩国这次面子丢大了,美军士兵痛揍韩国人,亲美总统却失声了

腾讯网2022-12-07 09:01:03

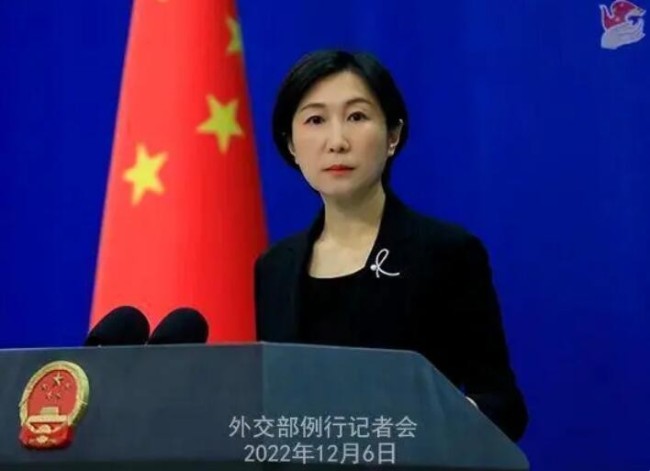

布林肯发涉中国防疫言论 中方回应 这几年中国疫情防控方针政策是正确、科学、有效的

环球网2022-12-07 09:36:02

媒体:久违了!欢迎回家过年 一句话抚慰漂泊游子心

2022-12-07 10:02:01

老师用收费软件布置作业?学校回应

2022-12-07 09:58:54

俄媒:泽连斯基正拍卖乌克兰,美国只能借机收割欧洲资本

腾讯网2022-12-07 09:07:33

朝鲜连续实弹射击反制韩美军演 韩军多次向朝鲜发出警告

环球网2022-12-07 09:33:53

媒体:泽连斯基打算一锤定音拍卖乌克兰,果然有“头脑”

海外网2022-12-07 09:04:27

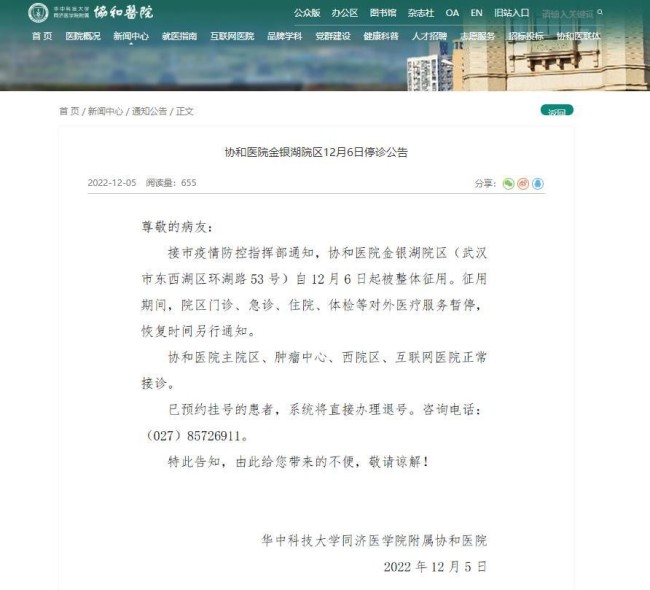

武汉协和医院金银湖院区被整体征用 已在该院区预约挂号的患者,系统将直接办理退号

央广网2022-12-07 09:37:28

辞职后连夜逃亡的贪官出镜痛哭:东窗事发,一逃了之

2022-12-07 10:17:09

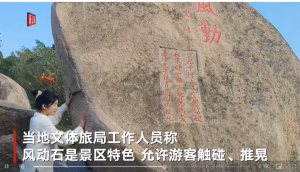

景区回应多人推山顶“风动石”:景区特色 允许推

新京报2022-12-07 10:10:15

马斯克在一张风景图下的评论火了:画面来自欧盟最贫穷国家

2022-12-07 09:47:36

曝李四川接受邀请将出任台北副市长 在蒋万安“三顾茅庐”之后已决定接受蒋邀请

中国台湾网2022-12-07 09:29:51

“现在还有人质疑我访华,我觉得很奇怪”

2022-12-07 08:46:27

俄军装备“上新” 新一批苏-35S战机即将抵达,开足马力生产了

央视网2022-12-07 09:18:01

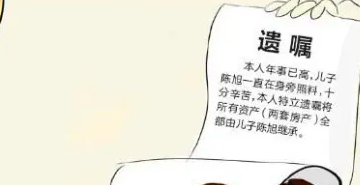

老人立遗嘱不给妻子遗产 法院:所立遗嘱无效

2022-12-07 09:39:18

官方回应洛阳过年是否让放鞭炮:禁运、禁售、禁放

2022-12-07 09:53:35

1.5万乌军在巴赫穆特被“包饺子”,俄称发现大批外国雇佣兵

海外网2022-12-07 08:58:20

全国单日票房一度超4000万 郑州广州影院恢复营业

2022-12-07 09:34:10

中俄达成重磅协议,面对西方的经济绞杀战,俄罗斯终于能喘口气了

海外网2022-12-07 08:49:08

男孩时隔4个月见父母礼貌喊叔叔 引发无数父母感慨

2022-12-07 10:21:11